En général, lorsque j’ai accès à un compte Google Analytics, j’essaie rapidement de déterminer si les données sont exactes (ou polluées). La plupart du temps, Google Analytics contient du spam. Pour les petits sites web, il représente parfois jusqu’à 30 % des sessions !

L’effet secondaire du trafic de spam ? Vous ne pouvez vous fier à aucune donnée générale. Elles altèrent votre compréhension du profil des visiteurs. Réglons ce problème.

Mais d’abord…

Qu’est-ce que le trafic de spam ?

Certains spécialistes du marketing numérique du “dark web” tentent d’obtenir de la visibilité (du trafic) pour leurs sites web. L’un des moyens pour eux est de se faire remarquer via votre compte Google Analytics. Ils utilisent des robots d’indexation pour générer de “fausses” visites sur l’ensemble du web.

Les fausses visites peuvent augmenter votre trafic (et votre ego), mais elles sont inutiles pour votre entreprise.

Mes données analytiques sont-elles affectées ?

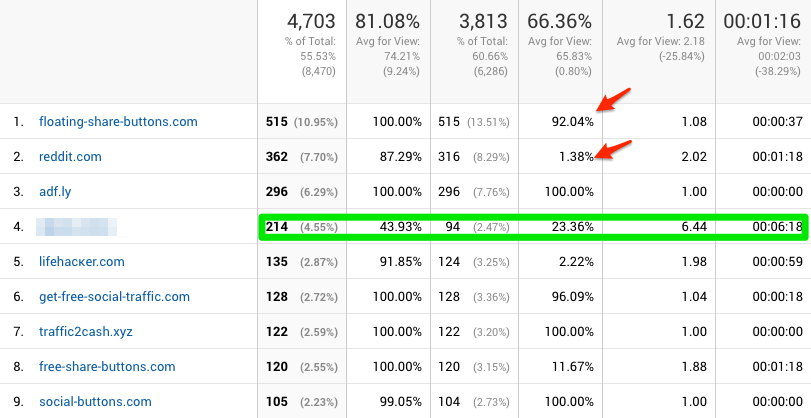

Probablement oui. Pour vous en assurer, connectez-vous à votre compte Google Analytics et accédez à la page Acquisition > All Traffic > Referrals.

Concentrez-vous sur toutes les “sources de référence étranges” qui ont.. :

- Un taux de rebond trop faible ou trop élevé.

- Le temps moyen passé sur place est très court.

- Un taux très élevé de nouveaux visiteurs.

Pour ce site, près de 50% du trafic provient de références, et 90% de ce trafic est inutile parce qu’il s’agit de spam. La seule source valable est celle qui est floue…

Nous devons nettoyer ces données pour obtenir une meilleure vue d’ensemble.

Exclusion du trafic de spam dans les rapports Google Analytics

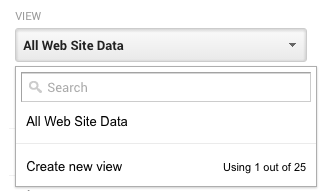

Pour nettoyer vos vues, nous devons d’abord nous assurer que nous disposons d’une sauvegarde. Nous allons conserver l’ancienne vue “brute” et polluée et en créer une nouvelle pour les comparer. Malheureusement, la nouvelle vue ne contiendra pas de données historiques.

Dupliquer votre vue Google Analytics

- Allez dans l’onglet admin et ajoutez une nouvelle vue dans votre propriété.

- Dans cette nouvelle vue : Allez dans Paramètres de l’affichage et cochez “Filtrage des robots : Exclure tous les hits provenant de robots et d’araignées connus”. (Cela aidera mais ne résoudra pas entièrement le problème).

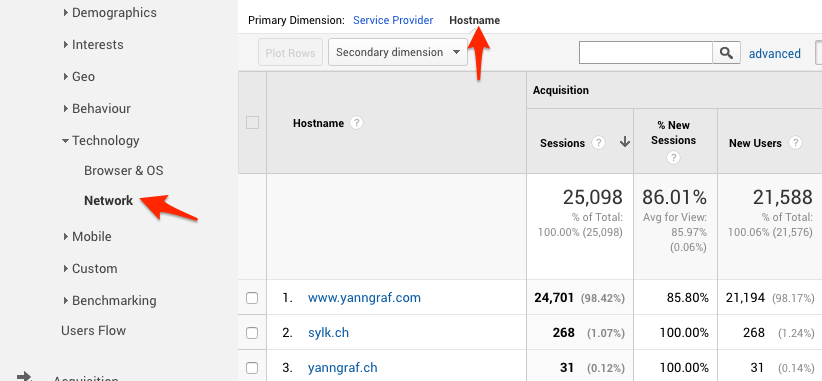

Trouvez vos noms d’hôtes valides

Parfois, les spammeurs font mal leur travail et ne définissent pas de nom d’hôte, ou en utilisent un étrange.

Dans l’ancienne vue “brute”, allez à Audience > Technology > Network et passez au nom d’hôte. Veillez également à sélectionner un intervalle de temps plus large. Peut-être un an.

Vous devriez voir apparaître une grande variété d’URL. Copiez maintenant toutes les URL valides, généralement votre nom de domaine et ses alias.

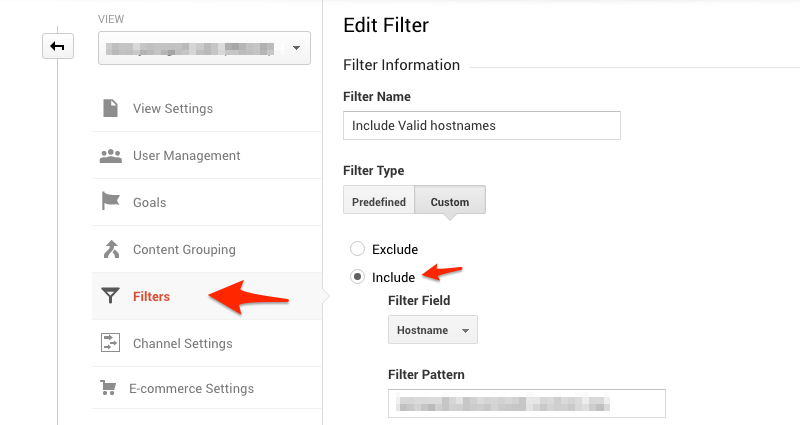

Nous créerons ensuite un filtre dans la nouvelle vue, qui n’inclura que le trafic avec ces noms d’hôtes valides.

Allez dans l’onglet Admin > Filters > Créez un nouveau filtre avec un type de filtre personnalisé. Et un champ de filtre“include” avec “hostname”. Remplissez le filtre de motif. Dans le cas de mon site web, le motif du filtre serait “yanngraf|sylk|archive.org”. Remarque : Sylk.ch était le domaine initial de ce site.

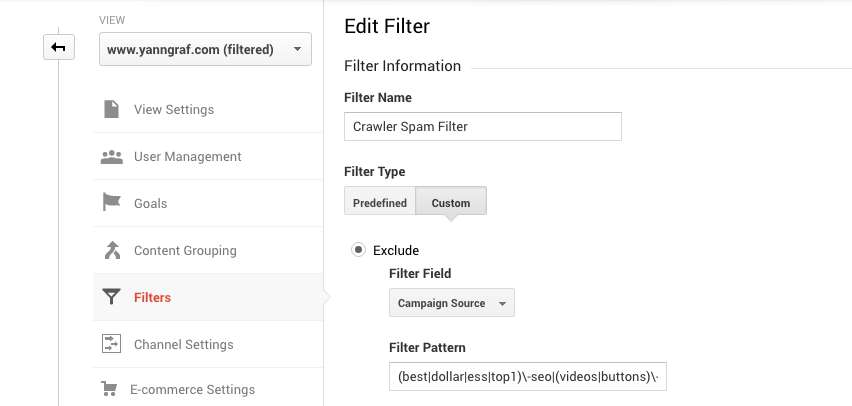

Exclure les spams supplémentaires de Crawler

Nous devons maintenant aller plus loin et exclure les spams supplémentaires du robot d’exploration. Dans les filtres, créez un nouveau filtre personnalisé. Mais cette fois-ci, utilisez l’option d’exclusion. Choisissez Campaign Source et collez le code ci-dessous dans le champ.

(best|dollar|ess|top1)\-seo|(videos|buttons)\-for|anticrawler|^scripted\.|\-gratis|semalt|forum69|7make|sharebutton|ranksonic|sitevaluation|dailyrank|vitaly|profit\.xyz|rankings\-|\-crew|uptime(bot|check|\.com)|responsive\-|tkpass|keywords\-monitoring

Et voilà, maintenant que vos données sont propres, il est temps de vous assurer que vous commencez à suivre vos conversions.

N’hésitez pas à me contacter si vous avez des questions ou si vous avez besoin d’aide pour mettre en place le suivi sur votre site web.